Was ist RAG in KI: Eine einfache Anleitung zur Retrieval-Augmented Generation

Retrieval-Augmented Generation (RAG) in KI bezieht externe Daten ein, um die Genauigkeit der Modellantworten zu verbessern. Diese Technik stellt sicher, dass die Ausgaben aktuell und kontextrelevant sind. In diesem Artikel werden wir behandeln, was RAG in KI ist, wie es funktioniert und welche Vorteile es hat.

Retrieval-Augmented Generation (RAG) verstehen

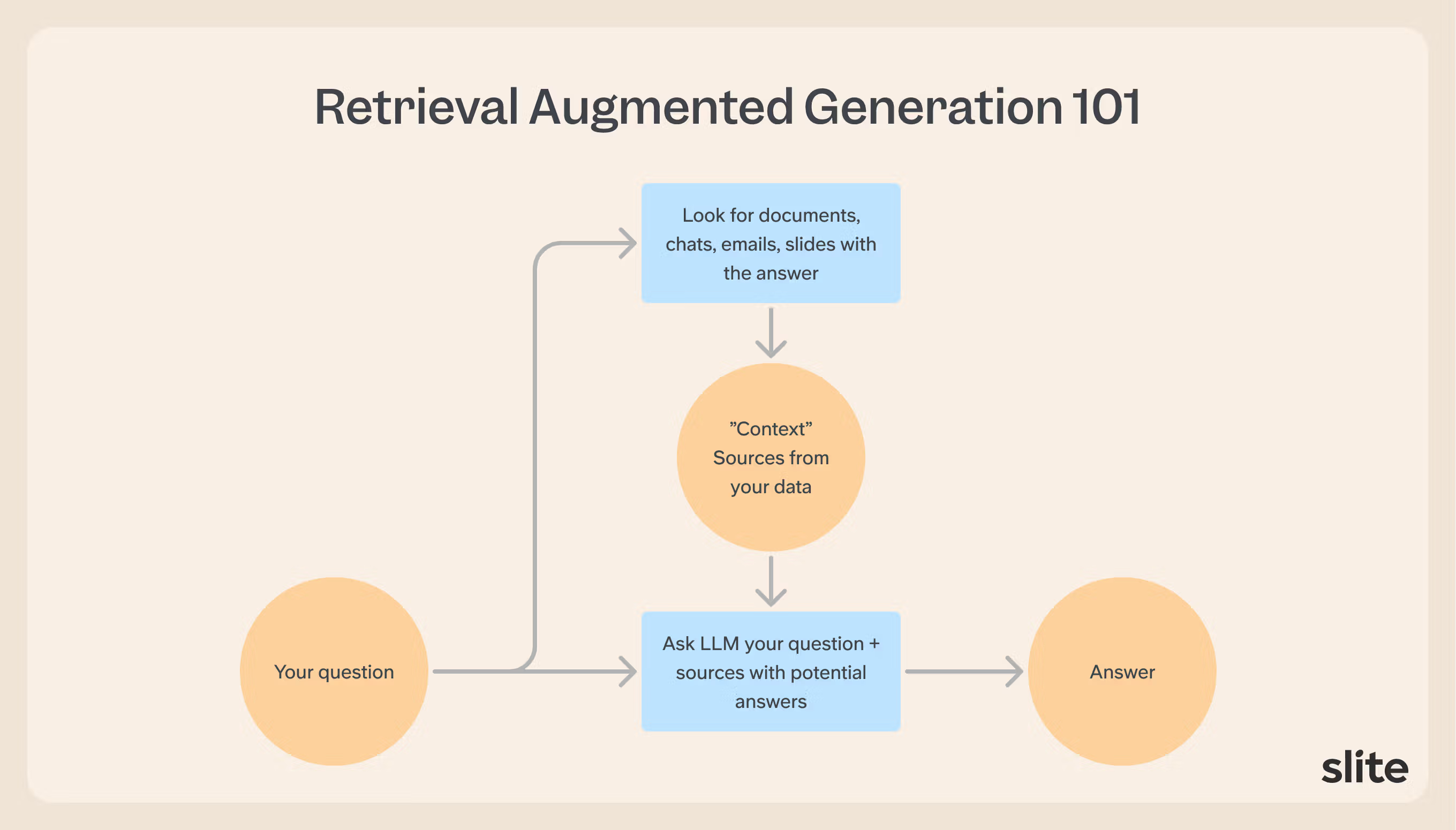

RAG (Retrieval-Augmented Generation) ist die Art und Weise, wie KI auf bestimmte Informationen zugreift. Es kombiniert Informationsabruf und Sprachgenerierung, um Antworten zu verbessern.

Das System arbeitet in mehreren Schlüsselschritten:

- Es indiziert alle verfügbaren Dokumente, pflegt Standortreferenzen und stellt der KI relevanten Kontext zur Verfügung

- Dokumente werden in Vektoreinbettungen umgewandelt, wodurch thematische Cluster und Relevanzmarkierungen erstellt werden

- Beim Empfang einer Anfrage verarbeitet es die Frage, durchsucht die Vektordatenbank und identifiziert relevanten Kontext

- Das System extrahiert relevante Informationen und stellt sie dem Basismodell zur Antwortgenerierung zur Verfügung

Zu den Hauptvorteilen von RAG gehören:

- Höhere Genauigkeit durch Quelldokumente

- Aktueller Informationszugriff

- Quellenangabe

- Zuverlässigere und überprüfbarere Antworten

Dieser Ansatz löst ein grundlegendes Problem bei Standard-KI-Modellen, die allgemeines Wissen aus ihren Trainingsdaten enthalten, das in der Regel um Monate oder Jahre veraltet ist. RAG schließt diese Lücke, indem es den Zugriff auf aktuelle Dokumentation, aktuelle Ereignisse und private Datenbanken ermöglicht.

In der praktischen Implementierung hat RAG signifikante Ergebnisse gezeigt und eine Verbesserung der Antwortgenauigkeit um 63 % erzielt, indem externer Wissensabruf mit der LLM-Generierung integriert wurde. Die Entwicklung von RAG

Retrieval-Augmented Generation (RAG) lässt sich bis in die 1970er Jahre zurückverfolgen, eine Ära, in der erste Modelle von Frage-Antwort-Systemen von Innovatoren auf diesem Gebiet konzipiert wurden. Diese prägenden Phasen legten eine solide Grundlage für Fortschritte in den Technologien der natürlichen Sprachverarbeitung, die folgen sollten.

Erst mit dem Aufkommen von Ask Jeeves Mitte der 1990er Jahre erlangte diese Technologie durch die Erleichterung von natürlichsprachlichen Abfragen breite Aufmerksamkeit.

In einem bedeutenden Fortschritt für die RAG-Technologie veröffentlichten Forscher von Meta unter der Leitung von Patrick Lewis im Jahr 2020 eine einflussreiche Studie, die nicht nur das Akronym „RAG“ etablierte, sondern auch eine neue Architektur für die Anwendung dieses Konzepts innerhalb moderner KI-Frameworks enthüllte.

Seitdem ist Retrieval-Augmented Generation ein zentraler Bestandteil der hochmodernen Forschung und Innovation in künstlichen Intelligenzkreisen und hat zahlreiche wissenschaftliche Artikel und praktische Implementierungen in verschiedenen Anwendungen im Zusammenhang mit natürlicher Sprachverarbeitung und Frage-Antwort-Systemen inspiriert.

Wie RAG große Sprachmodelle verbessert

RAG verbessert große Sprachmodelle auf verschiedene Arten:

- Es schließt die Lücke zwischen allgemeinem Wissen und aktuellen Informationen, indem es KI mit spezifischen Datenquellen verbindet

- Es ermöglicht eine höhere Genauigkeit durch Quelldokumente, aktuellen Informationszugriff und Quellenangabe, wodurch Antworten zuverlässiger und überprüfbarer werden

- Es trennt die Fähigkeit des LLM, Antworten zu generieren, von seiner Fähigkeit, Faktenwissen abzurufen

- Es bietet eine Verbesserung der Antwortgenauigkeit um 63 %, indem externer Wissensabruf mit der LLM-Generierung integriert wird

- Es ermöglicht KI, Fakten nachzuschlagen, anstatt zu raten oder sich Dinge auszudenken

- Es ermöglicht Wissensaktualisierungen, ohne dass ein Modelltraining erforderlich ist

Das System funktioniert wie folgt:

- Konvertieren von Dokumenten in Vektoreinbettungen

- Erstellen von thematischen Clustern und Relevanzmarkierungen

- Verarbeiten von Abfragen, um relevanten Kontext zu identifizieren

- Extrahieren von Informationen und Bereitstellen für das Basismodell zur Antwortgenerierung

Die Architektur von RAG besteht aus verschiedenen Segmenten, die der Verarbeitung von Anfragen, dem Abrufen relevanter Informationen aus externen Datenbanken und der Erstellung kohärenter Antworten dienen. Eine solche systematische Methode mildert häufige Fallstricke wie Ungenauigkeiten und erfundene Aussagen, die häufig in Standard-KI-Modellen zu sehen sind. Infolgedessen erlebt RAG aufgrund dieser Fortschritte, die durch die RAG-Technologie erzielt wurden, einen eskalierten Einsatz in verschiedenen Branchen, die darauf abzielen, Entscheidungsprozesse zu verbessern und die Kundenbindung zu verbessern.

Die Mechanik von RAG

Retrieval-Augmented Generation (RAG) verwendet eine ausgeklügelte Abfolge von Schritten, um KI-generierte Antworten zu verbessern. Zunächst beinhaltet diese Methode das Aufteilen großer Datenmengen in besser handhabbare Teile zur besseren Handhabung. Anschließend wird die Abfrage des Benutzers durch ein Einbettungsverfahren, das die Übereinstimmung mit Einträgen in Vektordatenbanken erleichtert, in Vektorform codiert.

Nach dem Abrufen relevanter Informationen aus diesen Datenbanken verbessert RAG die Eingabe durch die Verwendung von Taktiken wie Prompt Engineering und der Strukturierung von Dokumentauszügen. Die erweiterte Eingabe dient dann als Grundlage für die Erstellung von Antworten, die nicht nur präzise, sondern auch kontextuell passend sind.

RAG verfügt über Mechanismen zur automatischen Aktualisierung externer Dokumente zusammen mit ihren jeweiligen Vektoren in seiner Datenbank, um die Aktualität und Relevanz der während des Abrufs verwendeten Informationen aufrechtzuerhalten.

Schlüsselkomponenten eines RAG-Systems

Hier sind die Schlüsselkomponenten eines RAG-Systems:

- Dokumentenverarbeitungssystem

- Konvertiert Dokumente in Vektoreinbettungen

- Erstellt thematische Cluster und Relevanzmarkierungen

- Pflegt indizierte Referenzen

- Wissensbasis

- Enthält gesammelte Informationen für den KI-Zugriff

- Speichert Vektoreinbettungen

- Verwendet Dokumentenblöcke von etwa 512 Token

- Abrufsystem

- Verarbeitet eingehende Abfragen

- Durchsucht die Vektordatenbank

- Verwendet einen hybriden Ansatz, der Folgendes kombiniert:

- BM25 für Schlüsselwortgenauigkeit

- Dichter Abruf für semantisches Verständnis

- Beinhaltet Cross-Encoder-Reranking

- Integrationsmechanismus

- Extrahiert relevante Informationen

- Stellt dem Basismodell Kontext zur Verfügung

- Verwendet dynamische Prompt-Konstruktion

- Pflegt ein gleitendes Fenster von Kontext-Token (2048)

- Generierungskomponente

- Kombiniert abgerufene Informationen mit Sprachkenntnissen

- Erstellt natürlichsprachliche Antworten

- Erstellt Antworten mithilfe von Quelldokumenten

Während der Abrufphase wird ein Verfahren durchgeführt, das als Aufbau einer Wissensbasis bezeichnet wird, um den Zugriff auf Informationen zu optimieren. Dieser Schritt konvertiert Daten in Vektoreinbettungen – numerische Array-Darstellungen, die den Inhalt für Maschinen interpretierbar machen.

Anschließend wird in der Generierungsphase zuvor abgerufene externe Informationen mit der Benutzerabfrage integriert, um die von einem großen Sprachmodell (LLM) erstellten Antworten zu erweitern. Ein solches zweigeteiltes Framework garantiert, dass die von künstlicher Intelligenz bereitgestellten Antworten nicht nur präzise, sondern auch relevant sind und auf aktuellen Datenquellen basieren.

Vektordatenbanken

Vektordatenbanken sind für die Funktionalität von RAG-Systemen unerlässlich, da sie Einbettungen enthalten und innovative Suchoptionen für den Vektorabgleich bieten. Die Einbettungskonvertierung wandelt Textsegmente in Vektoren um, die eine Vektordatenbank speichert, wodurch der Prozess für den schnellen und relevanten Datenabruf gemäß den Benutzerabfragen optimiert wird.

Obwohl sie für RAG-Systeme nicht unbedingt erforderlich sind, verbessert die Einbeziehung von Einbettungen oder Vektordatenbanken ihre Abruffähigkeiten erheblich. Durch die Korrelation von Einbettungen mit Originalquelldaten können generative Modelle genauere Antworten erstellen und Indizes innerhalb von Wissensbasen aktualisieren, um aktuelle und vertrauenswürdige Informationen zu erhalten.

Semantische Suche

Die semantische Suche funktioniert, indem sie Dokumente identifiziert und abruft, die ein hohes Maß an Ähnlichkeit mit den Einbettungen der Abfrage aufweisen, im Gegensatz zur herkömmlichen Schlüsselwortsuche, die von der genauen Übereinstimmung von Wörtern abhängt. Indem sie die Absicht hinter Benutzerabfragen erfasst, übertrifft die semantische Suche herkömmliche Methoden und ermöglicht es ihr, effektiver relevantere Informationen bereitzustellen. Das robuste Verständnis von natürlichsprachlichen Fragen ebnet den Weg für Antworten, die nicht nur genau, sondern auch kontextbezogen sind.

Forschungsentwicklungen von Unternehmen wie Facebook AI Research – derzeit bekannt als Meta – haben semantische Suchtechnologien in die Lage versetzt, sowohl strukturierte als auch unstrukturierte Daten, die aus einer Reihe von Quellen stammen, darunter Unternehmensrepositorys und Webseiten, gekonnt zu durchsuchen. Solche Fortschritte unterstreichen ihre wichtige Rolle innerhalb von RAG-Systemen, indem sie sicherstellen, dass sie relevante Erkenntnisse liefern, wenn sie auf Benutzeranfragen antworten.

Anwendungen von RAG in verschiedenen Branchen

Die Anpassungsfähigkeit des RAG-Systems macht es für zahlreiche Sektoren geeignet. Es kann verschiedene Informationsspeicher anzapfen, die private Inhalte wie E-Mails, Notizen und Artikel umfassen, und so die Bereitstellung umfassender Antworten ermöglichen, die aktuelles Wissen widerspiegeln. Die in RAG integrierten externen Daten können aus APIs, Datenbanken, Dokumentensammlungen und anderen Kanälen stammen, wodurch die Bandbreite der zugänglichen Informationen erweitert wird.

RAG verwendet mathematische Algorithmen, um festzustellen, wie relevant gesammelte Dokumente in Bezug auf Benutzerabfragen sind. Dieser Prozess erhöht nicht nur die Benutzerbindung, sondern verbessert auch die betriebliche Effizienz von Konversationsschnittstellen. Gleichzeitig untersuchen Forscher Möglichkeiten, RAG mit zusätzlichen KI-Methoden zu kombinieren, um diese interaktiven Erfahrungen voranzutreiben.

Kundenservice

Im Bereich des Kundenservice ermöglicht RAG Benutzern, interaktive Abfragen innerhalb von Datenrepositorys durchzuführen und so die Fähigkeiten generativer KI zu erweitern. Durch die Implementierung von RAG können Chatbots, die Kunden bedienen, Antworten anbieten, die sowohl präzise als auch kontextrelevant sind, was die Benutzerbindung erheblich verbessert. Folglich erleichtert dieser Fortschritt eine schnellere Lösung von Kundenproblemen, was zu einer verbesserten Antworteffizienz und einer höheren Gesamtzufriedenheit der Benutzer führt.

Mit RAG-Technologie ausgestattete Chatbots optimieren die Kundeninteraktion, indem sie genaue und relevante Antworten liefern, die auf Benutzerabfragen zugeschnitten sind. Diese Methode geht über die bloße genaue Beantwortung hinaus. Sie fördert ein ansprechendes und optimiertes Erlebnis bei Kundenservice-Begegnungen.

Gesundheitswesen

Im Bereich des Gesundheitswesens ist die Implementierung von RAG maßgeblich an der Entwicklung von Systemen beteiligt, die in der Lage sind, genaue Antworten auf gesundheitsbezogene Fragen zu liefern, indem sie auf umfangreiche medizinische Datenrepositorys zugreifen. Dies ermöglicht es medizinischem Fachpersonal, umgehend Informationen zu erhalten, was die Patientenbehandlung verbessert und die Forschungseffizienz steigert. Durch die Kombination von RAG mit bestehenden Protokollen können Fachkräfte im medizinischen Bereich relevante Details aus umfassenden klinischen Aufzeichnungen extrahieren und so ihren Entscheidungsprozess in Bezug auf die Patientenversorgung verfeinern.

Durch die Nutzung der RAG-Technologie gibt es eine bemerkenswerte Verbesserung bei der Einbindung von Patienten, da sie ihnen eine maßgeschneiderte Gesundheitserziehung bietet, die ihren individuellen Bedürfnissen und ihrem Verständnisniveau entspricht. Eine solche individualisierte Kommunikation garantiert, dass Patienten verständliche und genaue Gesundheitsfakten erhalten, die für sie relevant sind – diese Strategie fördert verbesserte Ergebnisse für das Patienten-Gesundheitsmanagement.

Finanzen

Im Finanzsektor unterstützt Retriever-Augmented Generation (RAG) generative KI-Modelle, die für die Bereitstellung präziser Antworten auf komplizierte Anfragen unerlässlich sind. Finanzunternehmen nutzen RAG, um externe Datenquellen effektiv zu integrieren und so schnelle und zeitnahe Antworten auf Kundenfragen sicherzustellen. Die Nutzung von RAG im Finanzwesen erstreckt sich über die Automatisierung von Kundensupportsystemen, die Verbesserung von Compliance-Überprüfungen und das Angebot maßgeschneiderter Anlageberatung.

Bei der Durchführung von Risikobewertungen ist RAG maßgeblich daran beteiligt, relevante Informationen aus einer Vielzahl von Datenpunkten zu aggregieren, um die Marktdynamik zu untersuchen. Diese Verbesserung der Datenextraktion ermöglicht es Finanzberatern, schnell auf aktuelles Wissen zuzugreifen, während sie mit ihren Kunden interagieren.

Durch die Förderung einer schnellen und genauen Kommunikation, die auf aktuellen Erkenntnissen basiert, die von generativen KI-Modellen wie RAG bereitgestellt werden, sichern sich Finanzinstitute eine vorteilhafte Position, um die Bedürfnisse ihrer Kunden zeitnah und kompetent zu erfüllen.

Vorteile der Verwendung von RAG in KI

Die Verwendung von RAG in KI bietet mehrere Vorteile:

- Es stärkt die Zuverlässigkeit generativer KI-Modelle, indem es überprüfbare Daten aus externen Referenzen integriert.

- Durch die Zusammenführung dieser Informationen werden Instanzen von fehlerhaften „halluzinierten“ Antworten deutlich reduziert und die faktische Genauigkeit sowie die Zuverlässigkeit erhöht.

- RAG gewinnt das Vertrauen und die Glaubwürdigkeit der Benutzer, indem es glaubwürdige Quellen zur Untermauerung seiner Antworten bereitstellt.

RAG spielt eine entscheidende Rolle bei der Verfeinerung der Interpretation von Benutzerabfragen, wodurch die Wahrscheinlichkeit falscher Antworten verringert und die Leistung bei Aufgaben verbessert wird, die umfangreiches Wissen erfordern. Seine Fähigkeit, exklusive Daten zu assimilieren, ohne dass ein spezielles Training für Modelle erforderlich ist, garantiert, dass diese KI-Modelle ständig aktualisiert werden, wodurch ihre Kompetenz im Wissensmanagement verbessert wird. Folglich dient RAG als unverzichtbares Instrument zur Verbesserung sowohl der Qualität als auch der Integrität von KI-generierten Ergebnissen.

Herausforderungen und Überlegungen

Die Bereitstellung von RAG ist zwar vorteilhaft, stellt aber auch eine Reihe einzigartiger Herausforderungen dar, die sorgfältige Aufmerksamkeit erfordern. Die Integration und Aufrechterhaltung von Verbindungen zu externen Datenquellen erfordert erhebliche technische Investitionen. Die Effizienz des Abrufs wird durch Aspekte wie das Volumen der Datenquelle, Netzwerkverzögerungen und die Abfragehäufigkeit beeinflusst. Daher ist es entscheidend, diese Variablen gekonnt zu verwalten, um sowohl die Rechen- als auch die finanziellen Kosten zu senken.

Die Gewährleistung einer genauen Quellenangabe in KI-generierten Inhalten wird zunehmend schwieriger, wenn Informationen aus verschiedenen Quellen zusammengeführt werden. In Fällen, in denen Daten von Drittanbietern sensible persönliche Daten enthalten, ist die strikte Einhaltung der Datenschutzgesetze obligatorisch.

Mit Blick auf die Zukunft könnten Fortschritte in der RAG-Technologie die Verarbeitung von Echtzeitinformationen verbessern und so Ungenauigkeiten in KI-produzierten Materialien reduzieren.

Die Zukunft der Retrieval-Augmented Generation

Retrieval-Augmented Generation (RAG) steht vor einer aufregenden Zukunft. Seit seiner Einführung in dem bahnbrechenden Papier von 2020 war RAG ein Katalysator für zahlreiche wissenschaftliche Artikel und reale Implementierungen in seinem Bereich. Entwickler sind jetzt in der Lage, Modelle im laufenden Betrieb zu aktualisieren und so den Zugriff auf aktuelles Wissen zu ermöglichen, das sowohl die Genauigkeit als auch die kontextuell relevanten Aspekte der von künstlicher Intelligenz generierten Ausgaben verbessert.

Da die Fortschritte in der RAG-Technologie weitergehen, liegt der Fokus auf der Integration von Mechanismen für den dynamischen Abruf externer Wissensquellen. Dies wird KI-Systeme in die Lage versetzen, mit erhöhter Spezifität in komplizierten Umgebungen zu arbeiten, die eine sofortige Erkennung des Kontexts erfordern. Die Entwicklung von RAG verspricht eine verbesserte kontextuelle Unterstützung. KIs werden bald nicht nur in der Lage sein, relevante Informationen zu finden, sondern auch Erkenntnisse anzupassen, die speziell auf die Ziele des Benutzers zugeschnitten sind.

Zusammenfassend

RAG markiert einen großen Meilenstein in der KI. Diese Technologie kombiniert Live-Datenabruffunktionen mit generativen KI-Modellen, um die Präzision, Relevanz und Zuverlässigkeit der von KI-Systemen erstellten Ausgaben zu verbessern. In verschiedenen Sektoren wie Kundensupport, Gesundheitsdiensten und Finanzmanagement revolutioniert RAG die Arbeitsweise von Branchen, indem es Interaktionen ermöglicht, die kontextuell angemessener und anspruchsvoller sind.

Da die Fortschritte in RAG voranschreiten, ist es bereit, noch bedeutendere Verbesserungen zu bieten – und KI als unverzichtbares Hilfsmittel in Alltagsszenarien zu positionieren.